Couleur science

La science de la nature pour les curieux Voir les Non lu | Plus vieux en premierComment fonctionnent les cierges magiques ?

Couleur science par Anonyme le 01/01/2026 à 05:21:00 - Favoriser (lu/non lu)

Parmi les quelques composés pyrotechniques d’intérieurs qui existent, figurent les cierges magiques. Ce sont des petites tiges que l’on enflamme comme une bougie, et cela produit ensuite des étincelles jaillissant sur les côtés. L’ensemble est sans réel danger : les étincelles ne brûlent pas, bien qu’une fois consumée, la tige métallique qui subsiste reste très chaude, chauffée au rouge en réalité.

Dans cet article on va voir la science qui se cache dans ces petits accessoires utilisées lors des fêtes.

Les cierges magiques sont constitués de plusieurs ingrédients responsables de la combustion et de la production d’étincelles :

- Un combustible : généralement de la poudre de charbon, de l’amidon, ou un sucre (dextrose, glucose).

- Un oxydant : habituellement du salpêtre (ou nitrate de potassium).

- Les composés métalliques responsables de la production d’étincelles : typiquement de l’aluminium, du magnésium, du titane ou du fer en poudre fine.

Ces ingrédients sont mélangés au sein d’une pâte, qui est ensuite enrobée autour d’une tige métallique puis séchée.

Lorsque l’on allume le cierge magique, le combustible et l’oxydant vont réagir. L’oxygène provient de l’oxydant et pas de l’air comme pour une bougie. Ceci favorise la combustion, car tous les ingrédients sont déjà en place. Et comme il n’y a pas besoin d’air, ils pourraient fonctionner sous l’eau (comme une arme à feu peut elle aussi fonctionner sous l’eau).

Durant cette combustion, les particules métalliques sont également enflammées. Ces dernières brillent très vivement : ce sont les étincelles. En général, on utilise des particules d’aluminium ou de magnésium pour les étincelles blanches et brillantes, et du fer pour celles qui sont plus orangées. D’autres couleurs peuvent être obtenues avec d’autres métaux : bleu-vert avec le cuivre, vert avec du baryum, violet avec du potassium…

Ce sont les mêmes que pour les feux d’artifices.

Les étincelles jaillissent à cause de la combustion très rapide qui provoque de micro-explosions en projettent ces particules tout autour. C’est aussi ce qui donne son bruit de crépitement.

Ces particules sont très fines : des poussières. Elles atteignent 1 000 à 1 500 °C, ce qui les rend visibles. Mais tout comme une étincelle d’une meuleuse par exemple, elles ne sont pas douloureuses sur la peau : leur température est peut-être très élevée, mais la chaleur qu’elles véhiculent (soit l’énergie thermique) est très faible à cause de leur petite taille.

Ces étincelles sont donc un autre exemple pour mettre en évidence la différence entre chaleur et température.

Il faut toutefois faire attention à ne pas les tenir trop près du visage, car elles peuvent toujours endommager les yeux.

En somme, ces cierges magiques sont de mini feux d’artifices et en comportent toutes les particularités chimiques : la présence d’un oxydant directement dans le matériau combustible (pour favoriser la combustion), et des inclusions de métaux pour produire des étincelles ou des flammes colorées !

Comment fonctionne une gomme ?

Couleur science par Anonyme le 04/12/2025 à 05:59:00 - Favoriser (lu/non lu)

On les utilise depuis la plus petite école, mais sait-on vraiment comment elles marchent ? Je parle des gommes, celles utilisées pour effacer du crayon à papier, et parfois du stylo.

Je distinguerais ici essentiellement trois techniques utilisées par les gommes pour effacer.

Les gommes tendres

La première méthode, est probablement la plus commune. Si l’on prend une gomme blanche, ou bien la partie rose des gommes mi-roses, mi-bleues bien connues, alors on a à faire à une matière souple et caoutchouteuse. Littéralement de la gomme.

Pour le crayon à papier, le fonctionnement d’une gomme en lui-même est lié au fonctionnement du crayon.

Une mine d’un crayon à papier est formé essentiellement de graphite, d’argile, et d’un liant plus ou moins gras. Plus il y a d’argile, plus la mine est claire et « grasse ». Le taux d’argile est alors soit haut, soit bas, sur une échelle qui a donné la nomenclature avec H/B (pour haut et bas : un 10H est fort en argile, fiable en graphite, clair et gras, alors qu’un 10B est au contraire riche en graphite, sombre et dur — le HB est au milieu).

Lors d’un tracé, la mine s’use sur le papier et se fixe dans les aspérités de ce dernier. La liaison entre le papier et la mine est essentiellement mécanique pour ce qui est des mines dures (donc « xB »). Pour les mines grasses, riches en argile et en liant, la mine subsiste aussi sur le papier par des liaisons moléculaires (forces de van der Waals…).

Une gomme blanche ou rose « caoutchouteuse » est à la fois poreuse et adhérente. Plus que le papier, en vérité. Grâce à cela, lorsque l’on frotte la gomme sur un dessin au crayon, le graphite se détache du papier et se colle alors à la gomme. La gomme, elle, est suffisamment tendre pour produire des sortes de « copeaux ». Ces copeaux sont alors éliminés avec le graphite collé dessus et la gomme reste propre, mais elle finit par s’user.

Ajoutons qu’avant l’invention de ces gommes, c’était de la mie de pain qui était utilisée pour retirer les traits du crayon. Et avant l’invention des mines de crayon à base de graphite et d’argile, c’était une pointe en métal qui était utilisée, typiquement du plomb (plomb, qui se dit “lead” en anglais, et qui est encore aujourd’hui le terme désignant une mine d’un crayon dans une partie des langues germaniques).

Ces gommes-là agissent donc par une action mécanique en détachant littéralement le tracé du papier. Aussi, elles fonctionnent très bien sur les mines sèches (crayon à papier), mais un peu moins sur les mines grasses, telles que les crayons de couleur : ces dernières finissent par s’étaler grassement sur le papier et à inhiber la formation des copeaux de la gomme, qui finit alors salie. De plus, si l’on a fortement appuyé lors de l’écriture au crayon, la mine se fixe trop profondément dans les aspérités du papier et la gomme ne peut plus la retirer.

Les gommes bleues, abrasives

La confection d’une gomme est un équilibre entre plusieurs paramètres :

- la dureté, pour mieux frotter ;

- la souplesse et l’élasticité, pour ne pas abîmer le papier ;

- adhérence, pour mieux accrocher le graphite se trouvant sur le papier.

Les gommes bleues sont-elles nettement moins souples, et également bien plus abrasives, à cause de l’inclusion de grains de sable (de la pierre ponce) comme sur du papier de verre.

Leur fonctionnement est identique à la partie rose de la gomme, mais ils servent alors à effacer du crayon sur des surfaces plus dures : carton, bois, murs… sur lesquelles on peut appuyer davantage. L’explication disant que cette partie de la gomme sert à effacer le stylo est une semi-légende, entretenue par par les fabricants de gommes elles-mêmes, par le marquage d’une pointe de stylo sur la partie bleue.

Pourtant, n’importe qui ayant essayé a vite remarqué que cela ne fonctionnait pas vraiment. Ceci pour une raison assez simple : l’encre du stylo a tendance à pénétrer profondément dans le papier, pas rester en surface comme le crayon, et donc pour effacer ça, il faut y aller bien plus durement, souvent jusqu’à détruire le papier lui-même, ce qui n’est pas but. Pas de problème cependant sur une surface assez solide (carton, bois, un mur) : ici on peut abraser le support pour retirer le crayon (ou l’encre, mais par abrasion du substrat plus que par retrait du tracé).

Il y a pourtant une méthode pour effacer le stylo ! Enfin… certains stylos. Et c’est avec un troisième type de gomme !

Les gommes FriXion® thermoréactives

FriXion est une marque du fabricant de stylos Pilot. Ce stylo est effaçable avec une gomme. Ici cependant, le principe est totalement différent des gommes pour crayons au graphite.

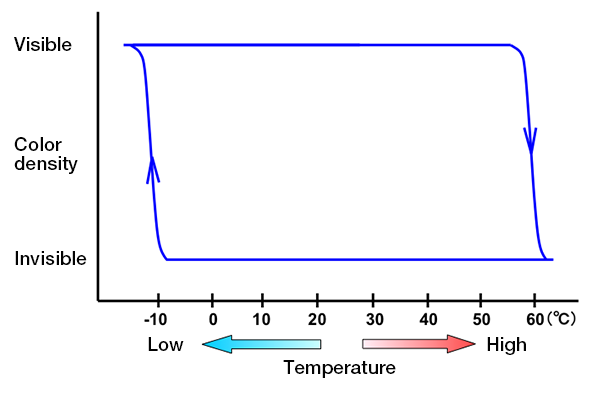

L’action pour les gommes pour crayons est mécanique, mais celui pour les stylos FriXion est thermochimique : l’encre utilisée dans ces stylos est thermosensible avec un fort phénomène d’hystérésis.

L’encre est visible à température ambiante et lorsqu’on achète le stylo, mais dès qu’on le chauffe autour de +60 °C, il réagit et devient invisible.

L’échauffement pour le rendre invisible (ie : l’effacer) est le rôle de la gomme : frotter la gomme sur l’encre réchauffe localement le papier et l’encre.

L’effet d’hystérésis signifie que l’encre ne réapparaît pas immédiatement en refroidissant à température ambiante. Il est possible de la faire réapparaître, mais il fait refroidir bien en dessous de la température ambiante, à des températures de l’ordre de −10 °C :

C’est donc différent des encres thermochromiques utilisées dans les tasses thermoréactives ou les bijoux d’humeur : là, l’encre change de couleur lorsqu’elle passe au-dessus d’une température donnée, mais reprend sa couleur initiale si la température repasse en dessous. Les deux transitions se font donc à la même température : il n’y a pas d’hystérésis.

Avec l’hystérésis, l’encre des stylos FriXion® transite d’une phase visible à une phase invisible à +60 °C, et d’une phase invisible à visible à −10 °C. Entre les deux températures, l’encre subsiste dans l’état dans lequel il se trouve, sans bouger. L’hystérésis c’est ça : les deux températures de transitions (dans un sens, puis dans l’autre) ne sont pas identiques.

Ceci signifie aussi deux choses, pour ces stylos :

- un texte écrit avec un stylo FriXion® deviendra invisible sur le papier est chauffé. Par exemple, si le document est laissé dans une voiture au Soleil.

- inversement, un texte effacé avec une gomme peut redevenir visible si on le place au congélateur.

Pour ces raisons, ces stylos ne sont pas recommandés pour des écrits sensibles ou que l’on vise à être pérennes dans le temps.

Si cela est votre besoin, je recommande plutôt les stylos Fisher Space Pen, que l’on peut utiliser sur une plage de température allant de −35 °C et +120 °C et dont l’encre est censée rester inaltérée durant au moins un siècle. Ces stylos sont également remplis de science, notamment pour être capables d’écrire à l’envers et en apesanteur !

Conclusion

Les gommes que l’on trouve dans une trousse d’écolier fonctionnent de différentes façons, en fonction de la gomme en question. La plupart sont faites de caoutchouc naturel (latex), ou synthétique, auxquelles on incorpore des additifs comme du soufre (pour le rendre plus durable, des abrasifs (pour les gommes bleues) ou divers pigments.

Les gommes molles, en caoutchouc, fonctionnent par adhésion : il « colle » au graphite du crayon, simplement accroché sur le papier et le décolle ainsi du papier pour l’effacer.

Les gommes plus dures, notamment les gommes bleues contiennent des particules abrasives, typiquement de la pierre ponce, de la silice (du sable) ou du carbonate de calcium (un abrasif plus doux pour ne pas trop abîmer le papier). Ici l’action mécanique consiste à limer la surface du papier pour en retirer les pigments que l’on a écrits dessus, que ce soit du crayon ou du stylo. Le stylo lui-même n’est pas retiré, comme l’est le crayon, mais c’est toute une partie du papier qui l’est. Ceci abîme inévitablement le papier, et c’est pour ça qu’il n’est prévu à la base que pour les surfaces plus résistantes, comme le bois ou le carton.

Certaines gommes sont là pour des encres spécialement étudiées pour s’effacer, ou du moins s’invisibiliser sous l’action de la chaleur. La chaleur est apportée par l’action de frotter la gomme sur le papier. C’est ce qui se passe pour les stylos FriXion®.

Ici l’action n’est donc plus mécanique, mais thermochimique.

Ressources et liens

- Crayon — Wikipédia ;

- How do erasers work? - McGill University ;

- The Two Types of Erasable Ink and Why One Is Much Cooler Than the Other | Office for Science and Society - McGill University ;

- PILOT FRIXION COLOURS ERASABLE FELT TIP PENS ;

- The Science Behind Frixion Erasable Pens | Nippon.com ;

- How do erasers erase?| HowStuffWorks ;

- Mais à quoi sert vraiment la partie bleue de cette célèbre gomme d’écolier ? — Edition du soir Ouest-France — 28/09/2022 ;

Autres articles sur ce blog

Que se passerait-il si l'on tombe dans un trou noir ?

Couleur science par Anonyme le 06/11/2025 à 05:37:00 - Favoriser (lu/non lu)

Il y a beaucoup de fascination qui entoure les trous noirs cosmologiques, mais aussi beaucoup d’incompréhension.

Un trou noir n’est pas un monstre aspirateur de planètes et d’étoiles qui gobe tout ce qui se passe à proximité. On verra pourquoi dans cet article, mais le sujet principal aujourd’hui sera de répondre à la question : que se passerait-il si l’on tombait dans un trou noir ?

L’essence de la question porte sur l’aspect de la déformation de l’espace-temps associé à la proximité d’un trou noir, et sur la perception de ces déformations par quelqu’un qui tomberait dedans mais aussi par quelqu’un d’autre qui le regarderait tomber.

Populairement, les textes répondant à cette question nous apprennent que le temps se mettrait à s’écouler plus vite pour une personne qui tombe, mais que quelqu’un qui la regarderait, verrait au contraire la personne ralentir.

Si l’on n’est pas trop familier avec l’aspect relatif(viste) de l’espace-temps, ces explications peuvent sembler déroutantes, voire renforcer la confusion régnant autour de ces astres. Si ceci comporte son lot d’exactitudes et d’imprécisions, cela n’explique rien.

Qu’est-ce qui fait qu’un trou noir est un trou noir ?

Pour commencer, rappelons ce qu’est un trou noir et ce qu’il n’est pas. Un trou noir n’est pas un aspirateur à matière. C’est avant tout un astre. Et comme tout astre, il a une masse. Généralement une grande masse (plusieurs masses solaires), mais ce n’est pas obligatoire.

Avoir une masse est suffisant pour attirer les autres objets vers soi au moyen de l’attraction gravitationnelle. Un trou noir n’a pas de mécanisme spécifique à lui pour tout « aspirer » : il se contente de l’attraction gravitationnelle, comme les étoiles et les planètes. On pourrait se placer sur une orbite autour, vivre à « proximité » et même trouver une série de planètes orbitant un trou noir.

La différence qui fait qu’un trou noir est un trou noir ne réside donc pas dans une capacité, une force, particulière. Elle réside plutôt dans sa densité. La densité traduit le fait de mettre une masse donnée dans un volume plus ou moins grand. Plus un objet est dense, plus cette masse occupe un volume petit. Et dans le cas d’un trou noir, une masse importante est réduite à un volume minuscule : on parle de la masse d’une étoile dans le volume d’un petit astéroïde.

Ceci a une importance fondamentale. Pour comprendre cela, prenons un astre quelconque, par exemple la Terre. La force d’attraction entre nous et la Terre est donnée par la relation :

$$F = G \frac{m \cdot M_🜨}{r^2}$$

Où :

- G : est la constante de gravitation universelle

- m : notre masse

- M🜨 : la masse de la Terre

- r : la distance vous séparant du centre de masse de la planète.

Si vous êtes debout sur Terre, alors vos pieds sont plus proches du centre de la Terre que votre tête. Pour notre tête, notre r est plus grand et donc la force plus faible : votre tête est donc moins attirée par la Terre que vos pieds. Bien-sûr, pour une Terre qui a un rayon de 6 400 km, et vous qui ne faites que 1,7 m (donc 0,001 7 km), cette différence est minime, totalement imperceptible.

Comprimons maintenant la Terre dans un volume de la taille d’une bille. Désormais, si l’on est debout sur sa surface, votre taille n’est plus du tout négligeable par rapport à la distance au centre de la bille. La différence d’attraction subie par vos pieds et votre tête est immense ! Cette différence est à l’origine d’une force bien particulière, que l’on appelle la force de marée. C’est la même force qui est responsable des marées au sens populaire, dans la mer et les océans. Si la Terre est comprimée dans une bille, cette force de marée vous donnera l’impression de vous étirer très fortement : vos pieds seront davantage tirés vers le sol que votre tête.

Vous l’aurez compris : la masse joue dans l’attraction d’un astre, mais les dimensions (rayons de l’astre, distance à l’astre) jouent sur le gradient de cette force. Le rayon contribue même bien davantage à cause du r². Si le rayon est minuscule, alors la force d’attraction est gigantesque à la surface.

Un trou noir, comme je l’ai dit, c’est précisément une masse gigantesque dans un volume minuscule. Les trous noirs ont donc un champ gravitationnel énorme à leur voisinage. Or, c’est dans les champs gravitationnels intenses des trous noirs que l’on observe des phénomènes particulièrement intéressants… et étranges !

Conséquences d’une masse très concentrée

Tous les objets peuvent devenir un trou noir : il suffit pour cela de les comprimer dans un volume suffisamment petit. Il faudrait une pression incommensurable pour faire ça, mais les équations nous l’autorisent.

Bien-sûr, si l’on comprime quelque chose, cette chose a tendance à rebondir et à résister. C’est le cas d’un ressort par exemple, mais aussi des atomes et de toute la matière.

Pour la gravité, on a vu que plus on est proche du centre de masse, plus la force d’attraction est forte. Donc, si l’on comprime notre ressort suffisamment, alors sa propre gravité l’empêchera de se détendre. Cet exemple avec un ressort est valable, mais il faut bien comprendre qu’il faudrait le comprimer dans le volume 10 000 milliards de fois plus petit de celui d’un proton, ce qui semble impossible.

Toutefois, si l’on y arrivait, alors la gravitation subie par l’ensemble des atomes du ressort seraient plus importantes que la force de rebond du ressort, et ce dernier resterait là, hyper concentré, sans rebondir.

On dit ici que le ressort subit un effondrement gravitationnel : à ce niveau de densité, la gravitation l’emporte sur toutes les autres forces de l’univers. Et lorsqu’on a un effondrement gravitationnel infini, comme ici, on obtient un trou noir.

Si l’on comprimait la Terre dans une bille de 8,87 mm, alors cela le transformerait en trou noir aussi. Pour une étoile de plusieurs millions de km de diamètre, la taille à atteindre est de quelques dizaines de kilomètres (la taille d’une ville humaine, typiquement).

Les implications sont immédiates pour notre Terre transformée en trou noir. Déjà, à 0,9 mm du centre, se formerait une région de laquelle rien, ni même la lumière, ne pourrait sortir. Cette région n’a pas vraiment de surface, mais elle force ce que l’on appelle « le trou noir » : c’est la région qui est totalement noire (précisément parce que la lumière ne peut en émaner). On appelle cette surface[1] sphérique[2], l’horizon des événements. Il ne s’agit pas d’une surface physique, mais d’une région de l’espace d’où il est impossible de s’échapper une fois qu’on s’aventure dedans. À l’extérieur de cette région, la vitesse de libération est encore inférieure à la vitesse de la lumière, et on peut donc s’en tirer, mais pas de l’intérieur.

Ce que l’on appelle communément « trou noir » correspond donc à cet horizon et tout ce qu’il y à de l’autre côté (« dans » le trou noir, donc).

D’où cela vient ?

Pour pouvoir s’échapper de la pesanteur de n’importe quel astre, et donc se défaire de son attraction, il faut une force supérieure à son accélération de pesanteur : si l’on accélère vers le haut plus vite que la gravité nous accélère vers le bas, eh bien on s’élève. C’est ce que fait une fusée au décollage. La fusée maintient cette poussée durant toute son ascension. Mais on peut aussi communiquer toute cette énergie avec une simple impulsion de départ, comme le ferait une balle de fusil ou un trébuchet (pour lesquels les projectiles ne sont pas autopropulsés).

Il apparaît donc une question : quelle vitesse imprimer à un projectile à la surface d’un astre pour que ce projectile se défasse de l’attraction de l’astre ? Ceci se calcule. Il suffit d’intégrer (au sens mathématique) l’accélération de la pesanteur en surface pour obtenir une vitesse « critique » au-delà de laquelle le projectile ne retombera jamais. On parle de vitesse de libération, vl :

$$v_l = \sqrt{\frac{2 \cdot G \cdot M}{r}}$$

Où :

- G : est la constante de gravitation universelle

- M : la masse de l’astre

- r : la distance au centre de l’astre, typiquement sa surface, sinon une altitude quelconque au-dessus de la surface

Sur Terre la vitesse de libération est de 40 320 km/h (ou 11,2 km/s).

Si l’on imprime cette vitesse à un projectile situé à sa surface, alors sa vitesse lui permettra de s’échapper de l’attraction de la Terre et de ne jamais retomber. Bien sûr, la vitesse du projectile va diminuer avec l’altitude, mais l’accélération de la pesanteur diminue aussi avec l’altitude ! En somme, on peut dire que le projectile s’éloigne plus rapidement de la Terre qu’il ne perd en vitesse. La planète ne pourra donc pas retenir le projectile : il finit par s’échapper totalement de l’emprise gravitationnelle, vers l’infini… et au-delà, dans l’espace.

Pour la Terre, cette vitesse est de 11,2 km/s (à sa surface). Pour Jupiter, on parle de 59,5 km/s ; et pour le Soleil, 617 km/s.

Pour le trou noir, au niveau de son horizon des événements, la vitesse de libération atteint 299 792,458 km/s, c’est-à-dire la vitesse de la lumière.

Trous noirs et effets relativistes

Brèves généralités sur les effets relativistes

Je ne vais pas tout expliquer les implications de la relativité (voyez déjà mon article sur la relativité restreinte par exemple, et en attendant que j’en fasse un pour la relativité générale pour en citer quelques-unes). Résumons seulement cela en quelques phrases.

Ce que la relativité restreinte et générale apportent par rapport à la physique classique, ce sont des modèles mathématiques pour les phénomènes que la physique classique n’explique pas, tout en englobant cette dernière. La mécanique relativiste est donc une extension de la mécanique classique.

Cette extension a été rendue nécessaire après avoir constaté que la mécanique classique (Galiléenne & Newtonienne) ne suffisait pas pour expliquer le monde dans certains cas de figures, notamment les hautes vitesses et les forts champs gravitationnels.

La principale innovation apportée est le caractère non absolu de l’espace et du temps. En effet, si dans la vie courante le temps s’écoule et l’espace défile de façon identique pour tout le monde, partout et tout le temps, en dehors de la vie courante — en dehors du cadre de la mécanique classique — ce n’est plus le cas : le temps s’écoule en réalité différemment, et les longueurs ne sont pas les mêmes selon qui les mesure, quand, où et dans quelles circonstances.

Les principaux facteurs qui font que le temps et l’espace sont ainsi « déformés » selon le référentiel considéré, sont la vitesse de déplacement de ces référentiels les uns par rapport aux autres, et l’intensité du champ gravitationnel dans lequel il se trouve.

À simple titre d’exemple : si l’on se déplace à 87 % de la vitesse de la lumière, notre temps s’écoule deux fois plus lentement que pour une personne qui voit ce référentiel se déplacer. Caricaturalement, de deux personnes dont une part en voyage relativiste à 87 % de la vitesse de la lumière, si celui qui voyage voit passer un an, celui qui reste sur Terre verra passer deux ans (en d’autres termes, celui qui part en le 1ᵉʳ janvier 2025 pendant un an reviendra sur Terre le 1ᵉʳ janvier 2026 pour lui, mais le 1ᵉʳ janvier 2027 pour tout le monde sur Terre. Quand on dit que le temps est « fluide » et relatif à un référentiel, c’est exactement ça.

La relativité générale montre que des phénomènes similaires viennent s’ajouter à ça lorsqu’on prend en compte les effets de la gravitation. Une forte attraction gravitationnelle produit ainsi une déformation de l’espace-temps de telle sorte que le temps s’écoule plus lentement et que la métrique spatiale est, elle, contractée.

Tomber dans un trou noir

Considérons deux personnes, Alice et Bob : Alice va voyager dans un trou noir. Bob va garder ses distances et observer Alice. Le but de l’expérience est de décrire ce que verront Alice et Bob, chacun de leur côté, en gardant en tête que le trou noir modifie — notamment — l’écoulement du temps. On se doute qu’Alice va subir des effets relativistes que Bob ne connaîtra pas.

Ce que vit Alice qui tombe dans le trou noir

Alice tombe dans le trou noir. Elle va subir les effets de la gravitation du trou noir et traverser l’horizon des événements. Son voyage sera donc sans retour.

Bien qu’elle subisse des effets relativistes, elle ne les sentira pas : pour elle, tout se passera normalement : son référentiel reste — de son point de vue — tout à fait ordinaire. Son horloge continuera — pour elle, encore une fois — de fonctionner comme à l’ordinaire : il s’agit d’une chute « normale ». Elle ne verra même pas le moment où elle aura traversé l’horizon des événements.

Vu que le trou noir se trouve devant elle et pas derrière, il y a un gradient dans l’intensité du champ de pesanteur le long de sa trajectoire de chute : ce qu’elle verra donc en revanche, c’est la déformation de l’espace-temps située sur cette trajectoire : devant elle, et derrière elle. Devant Alice, en direction de la singularité, l’espace-temps est davantage déformé. Et derrière elle, il est moins déformé.

L’écoulement du temps, pour commencer : devant elle, le ralentissement est visible et d’autant plus prononcé qu’elle regarde loin. Si une montre était tombée un peu avant elle, Alice verrait cette montre tiquer moins vite, et même de moins en moins vite au fur et à mesure de la chute, jusqu’à s’arrêter une fois à la singularité. Fait remarquable : si le temps lui-même ralentit, la chute semble ralentir aussi, et la montre mettra un temps infini a rejoindre la singularité, du point de vue d’Alice qui suit l’horloge. Toutefois, Alice elle-même, qui reste dans son propre référentiel, avec son temps propre, atteindra bien la singularité en un temps fini (et la montre aussi, mais pas selon Alice).

En ce qui concerne l’espace, donc les longueurs spatiales, celles-ci sont comprimées : la montre pourrait sembler se rapprocher, même si en réalité il n’en est rien, et c’est même l’inverse. Bob, qui regarde tout ça, pourrait se dire qu’Alice se rapproche asymptotiquement de l’horloge. En réalité, Alice ne verra pas cela : d’une part, car son référentiel lui semble normal, mais d’autre part, car tout ce qui lui servirait à mesurer tombe avec elle !

Derrière Alice, c’est-à-dire pour Bob, le temps est moins ralenti. Le référentiel d’Alice voit son temps s’écouler plus lentement, donc c’est comme si le temps de Bob s’accélérait, du point de vue d’Alice. Alice verrait donc Bob évoluer de plus en plus vite : Bob vieillirait à vue d’œil. Ce qui pour Alice ne constitue que quelques minutes, correspond à plusieurs années pour Bob. Ce phénomène s’accélère au fur et à mesure de la chute. Chaque minute correspond peu à peu à une semaine, à un an, puis à 10 ans, puis à un siècle, et ainsi de suite.

Sa chute étant désormais impossible à annuler, elle verrait toute l’histoire future de l’univers qu’elle laisse derrière elle…

Ce que vit Bob qui regarde Alice tomber

Ce qui pour Alice est une chute à une vitesse perçue normalement, correspond pour le reste de l’univers à toute l’éternité qui passe. Bob, s’il était éternel, verrait Alice tomber indéfiniment, et de plus en plus lentement. Il ne pourra toutefois la sauver.

En vrai, Bob finirait par ne plus rien voir : en effet, Bob voit Alice grâce aux rayons de lumière issus d’Alice. Or si Alice traverse l’horizon des événements, la lumière tombe avec elle, sans pouvoir rejoindre Bob. Qui plus est, juste avant l’horizon des événements, le phénomène de redshift ferait que les longueurs d’onde des rayons de lumière d’Alice s’allongent : le domaine visible devient de l’infrarouge, puis des ondes radio, etc. Bob verrait Alice tomber et devenir de moins en moins visible, avant de disparaître dans l’obscurité, comme transparente, invisible.

Inversement, Alice recevrait toujours plus de lumière en provenance de Bob : il s’agit de la lumière émise par tout le futur de Bob.

Ceci est abstraction faite des effets gravitationnels (non forcément relativistes), qui ont en fait quelques effets néfastes supplémentaires sur la santé d’Alice. Les forces de marée, mentionnées plus tôt, sont les principales responsables ici. Si le trou noir est suffisamment massif, les forces de marée ne lui seront perceptibles que bien après qu’elle a franchi l’horizon des événements.

Ses effets feront que la différence d’attraction au niveau de ses pieds (considérant qu’elle tombe les pieds en avant) avec l’attraction au niveau de la tête deviennent très importante. Ces forces seront suffisantes pour disloquer Alice en deux, puis en quatre, puis en plein de morceaux, jusqu’au niveau cellulaire (chaque cellule sera coupée du reste), puis moléculaire, atomique, sub-atomique… Ce qui commence comme Alice sautant dans le trou noir finira comme une longue traînée de particules dirigées vers le centre du trou noir. On appelle ça la spaghettification.

En plus de ça, si le trou noir était déjà orbité par de la matière, alors la matière la plus proche du trou noir tourne si rapidement autour qu’elle s’échauffe jusqu’à émettre des rayons X, juste avant de traverser l’horizon des événements. Ces rayonnements étant létaux à haute dose, cela contribue également à la dégradation de la bonne santé d’Alice.

Conclusion

Ce qu’il faut comprendre avec la relativité, c’est que cette théorie tire son nom du fait que tout est relatif. Par relatif, on entend donc quelque chose qui se compare à autre chose, contrairement à quelque chose d’absolu, qui ne dépend pas d’une comparaison avec quelque chose d’autre.

Dans la vie courante, quelque chose d’absolu serait la couleur d’un objet, mais quelque chose de relatif serait son caractère clair ou foncé : il est plus foncé ou plus clair qu’un autre objet.

En relativité, ce sont les notions de temps (les durées), d’espace (les distance) et les vitesses qui sont relatives entre les référentiels. Deux référentiels, deux personnes si vous voulez, vont vivre des durées et des déplacements qui ne selon pas identiques en fonction de qui les mesure, et dans quel cas de figure, notamment de déplacement, ou d’intensité du champ de pesanteur.

Si je me déplace vers vous, alors la distance que j’ai parcourue sera plus courte pour moi avec ma règle que vous avec la vôtre. Similairement, la durée du trajet sera plus courte selon moi que selon vous. Ce n’est pas une impression, ni une imprécision : le temps s’écoule moins vite pour moi si je la mesure quand je me déplace.

La partie importante, en relativité, est le « pour moi » : tout est une question de point de vue. Tout, à l’exception de la vitesse de la lumière, et des lois physiques : ces deux choses sont les seules à rester absolues. Peu importe qui la mesure, quand, où, et dans quelles conditions : la vitesse de la lumière sera toujours la même.

Le champ de gravitation intervient aussi dans ces distorsions de l’espace et du temps tel que mesuré par les uns et les autres. Les durées vécues et les distances parcourues sont ainsi différentes selon qu’on se trouve dans un fort potentiel gravitationnel, ou un faible.

Ce cas de figure là est notamment présent dans la vicinité d’un trou noir. C’est donc pour cela que si une personne tombe dans le trou noir, le temps s’écoulera et les distances défileront différemment que pour quelqu’un qui est à bonne distance de l’astre massif.

J’insiste sur le fait que chaque personne ne ressentira rien : pour elle, tout sera normal. Ce n’est qu’en comparant notre perception à celle d’autres observateurs que l’on peut dire si notre temps ou notre espace s’écoule plus vite ou plus lentement que celui d’un autre.

Pour un trou noir, la gravitation est très sensiblement d’autant plus forte qu’on en est proche. En matière d’écoulement du temps, ce dernier est de plus en plus lent lorsqu’on s’en approche. Une personne qui tombe dedans aura une horloge ralentie, même si elle ne le ressentira pas elle-même. C’est quelqu’un situé plus loin du trou noir qui verra la personne ralentir jusqu’à l’infini. Inversement, la personne tombante verra cet observateur accélérer, jusqu’à vieillir à vue d’œil, lui et tout l’univers extérieur au trou noir.

Enfin, notons que ceci est ce que nous dit la relativité. La relativité est une théorie née des observations du cosmos. Elle nous prédit également d’autres choses, dont certaines ont à leur tour été confirmées par l’observation. C’est le cas des trous noirs eux-mêmes.

Toutefois, ce qui se passe dans le trou noir lui-même, reste un mystère : la théorie de la relativité ne fonctionne plus très bien à ces échelles : les résultats produits par leurs équations sont aberrants. Les phénomènes décrits dans cet article, concernant Alice et Bob sont basés sur des observations réelles. Les déformations temporelles et spatiales sont observées, néanmoins (mais pas pour des gens que l’on enverrait dans un trou noir, évidemment).

Notes

1. En vérité, il n’y a pas de surface physique solide, sur lequel on pourrait marcher. Il s’agit ici d’une surface au sens mathématique : une forme (ici : fermée et sphérique) avec un intérieur et un extérieur. Il s’agit donc plus d’une limite mathématique qu’une « surface ».

2. Pour un trou noir le plus simple, c’est-à-dire non rotatif et non chargé électriquement.

3. Précisons que si la masse est source d’un potentiel gravitationnel, il en est aussi pour toute forme d’énergie : la masse n’étant qu’une forme d’énergie parmi d’autres.

Pourquoi certains aciers sont-ils aimantables et d’autres non ?

Couleur science par Anonyme le 02/10/2025 à 05:01:00 - Favoriser (lu/non lu)

Le fer et l’acier sont ferromagnétiques : ils sont attirés par un aimant. Certains aciers, notamment une partie des aciers inoxydables par contre, ne le sont pas et cela peut surprendre. Voyons pourquoi, et en détails.

Un inox ?

Le fer et l’acier (non-inox) sont sensibles à l’action de l’oxygène, de l’eau, des acides… Le fer contenu dans l’acier s’oxyde et perd alors toute cohésion avec le reste du métal : l’ensemble s’effrite, expose alors des zones propres, qui vont alors s’oxyder à leur tour, s’effriter et ainsi de suite. Laissé au temps et aux éléments, l’acier normal finit totalement effrité et rouillé, perdant toute intégrité structurelle.

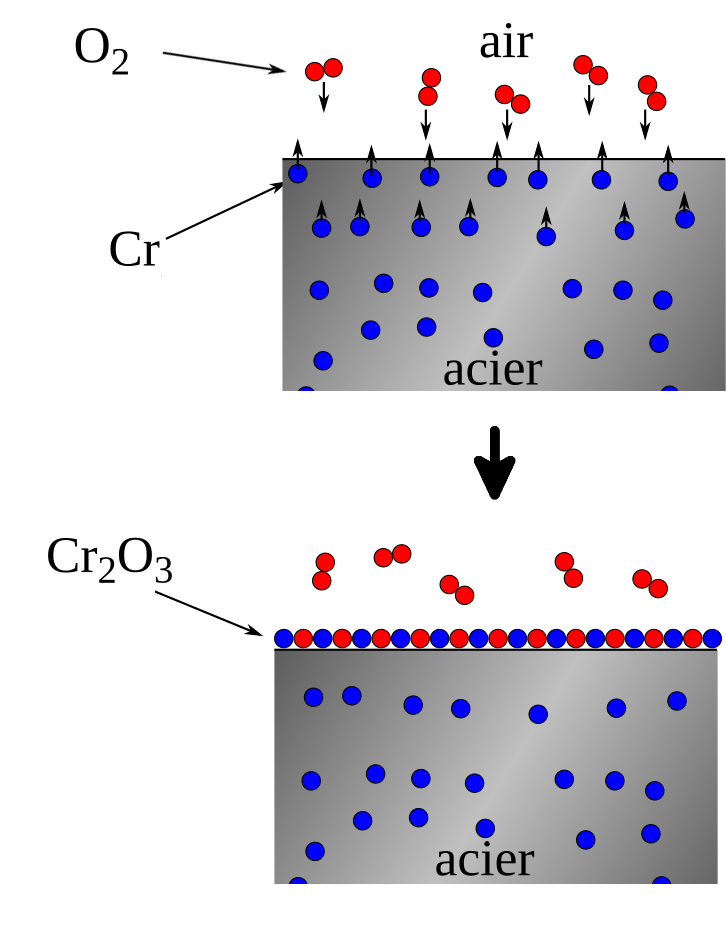

Ce que l’on appelle « inox » est le diminutif de « acier inoxydable ». Il s’agit d’un alliage d’acier — lui-même déjà un alliage de fer et de carbone — dans lequel on a incorporé quelques autres éléments, dont celui qui le rend résistant à l’oxydation : le chrome, à raison d’au moins 10,5 % de chrome, mais pouvant monter jusqu’à 30 %. Le chrome a une affinité plus importante que le fer avec l’oxygène, et il va s’oxyder en premier, en particulier le chrome en surface :

L’acier inox va très rapidement se recouvrir d’une couche d’oxyde de chrome. Contrairement à l’oxyde de fer cependant, l’oxyde de chrome est au contraire très résistant et va ainsi protéger le reste de l’acier, à la fois contre un effritement et contre toute rouille.

D’autres métaux ou alliages font sensiblement la même chose : aluminium, titane, argent, laiton, bronze… Ces métaux sont aussi sensibles à l’oxygène, mais leur surface est rapidement oxydée et protégée par cet oxyde. Ce phénomène, qu’il soit naturel ou provoqué de façon volontaire par un traitement de surface s’appelle la passivation.

L’acier « inox » est un terme générique qui désigne une large gamme d’alliages à base acier et chrome. La plupart du temps, on y ajoute également du nickel (autour de 10 %, mais parfois jusqu’à 35 %) pour le rendre plus solide. Pour la recherche de propriétés mécaniques, chimiques, de biocompatibilités plus fines, on peut y inclure également du titane, du molybdène, du tungstène, du vanadium… en quantité bien plus faible.

Voilà pour la présentation. Maintenant, pourquoi certains inox sont magnétiques et d’autres non ?

Une question de structure cristalline

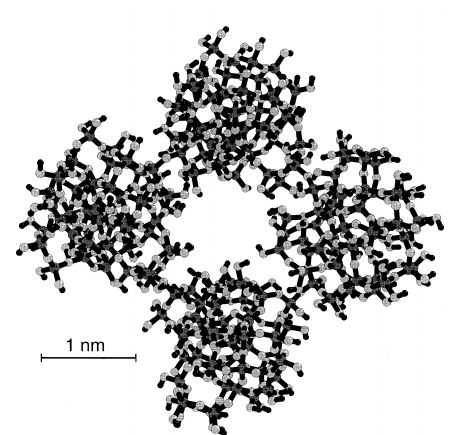

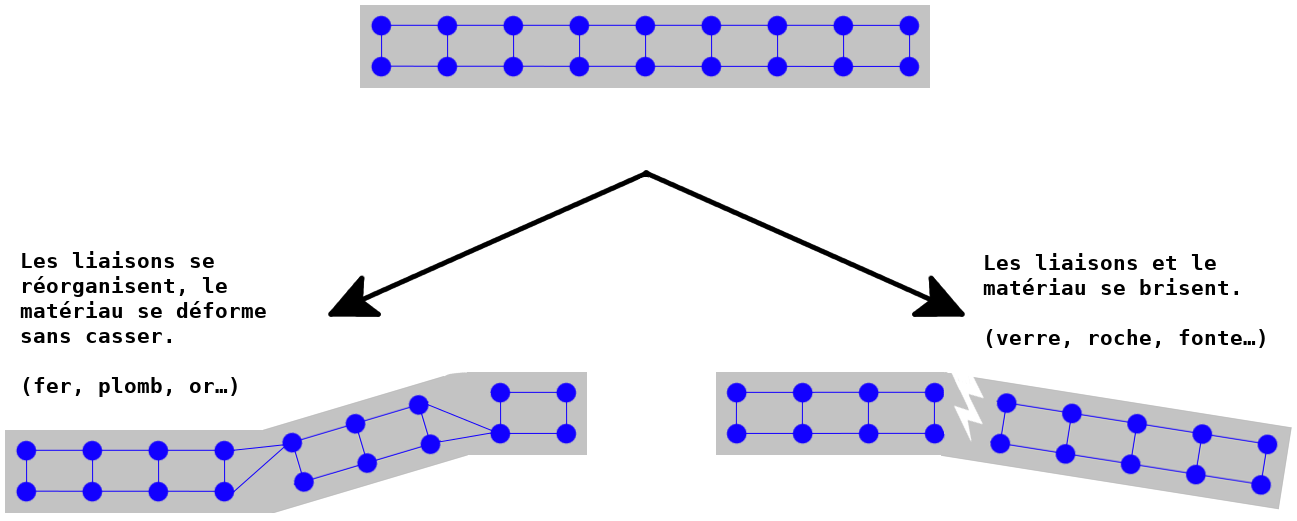

Au sein d’un matériau sous sa forme solide, les atomes sont le plus souvent organisés en motifs répétables : on parle alors d’un réseau cristallin. Certains matériaux peuvent se présenter sous plusieurs formes différentes, dépendant notamment des conditions présentes à sa formation : température, vitesse de refroidissement, pression, chimie du milieu…

C’est le cas du carbone, pour prendre un exemple bien connu. Si le motif cristallin est hexagonal plat, cela forme un empilement de feuillets appelés graphène et on obtient du graphite, le même que celui des mines de crayons. Si le motif est cubique, on obtient du diamant[1]. On dit que le diamant et le graphite sont deux allotropes du carbone (et il en existe d’autres). On constate déjà que différents allotropes ont des propriétés très différentes.

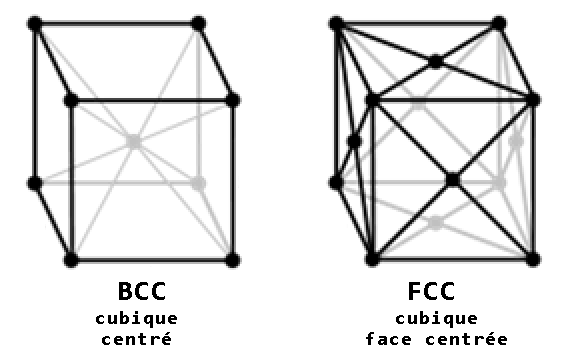

Le fer présente lui aussi un certain nombre d’allotropes, la plupart dépendant de la température. Ainsi, à température ambiante et jusqu’à 774 °C, le fer est dans sa forme fer-α (« fer alpha »), aussi appelé ferrite, qui est une configuration cristalline de type cubique-centré (body centred cubic, BCC).

Cela correspond à un maillage cristallin en forme de cubes avec un atome supplémentaire au centre du cube.

Entre 910 °C et 1 394 °C, les atomes se réorganisent et forment du fer-γ (« fer gamma »), appelé austénite. Il s’agit ici d’une configuration cubique face centrée (face centered cubic, FCC). La maille de base est toujours cubique, mais ici c’est chaque face du cube qui présente un atome en plus (et rien au centre).

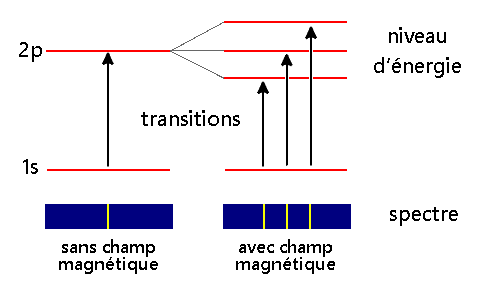

L’une ou l’autre de ces configurations prennent forme à cause de la recherche d’une stabilité du fer, notamment par le changement du moment magnétique de spin (ou simplement « spin ») des électrons non appairés des atomes de fer.

À son tour, le spin va déterminer la proximité des atomes entre eux, et par suite la structure cristalline du matériau dans son ensemble.

Vous l’aurez compris : différents types d’alliages d’aciers inoxydables ont des configurations électroniques différentes, ce qui produit des structures cristallines différentes aussi, et donc également différentes propriétés magnétiques.

À savoir que pour l’acier, la structure BCC est ferromagnétique, et la structure FCC est paramagnétique.

Différences entre le fer-α et le fer-γ

Dans le ferrite (fer-α, ferromagnétique, structure BCC), les électrons non-appairés des différents atomes de fer vont se stabiliser en adoptant des spins identiques.

Lors d’une excitation par un aimant, les moments magnétiques de tous les atomes s’alignent et le matériau est fortement attiré. Cet alignement est même rémanent : il subsiste après le retrait de l’aimant. C’est la raison pour laquelle certains tournevis, ou même une simple aiguille, restent aimantées après les avoir frottées à un aimant.

Dans l’austénite (fer-γ, paramagnétique, structure FCC) les atomes de fer sont plus proches les uns des autres que dans le ferrite. Les orbitales se recouvrent davantage et la stabilité s’atteint ici plutôt par un alignement antiparallèle des spins des électrons non-appairés.

Un champ magnétique extérieur a plus de mal à les orienter « de force », et l’attraction par un aimant est bien plus faible, voire inexistants. De plus, cette aimantation disparaît lorsque l’aimant disparaît

Et dans l’inox ?

L’inox est de l’acier avec un fort pourcentage de chrome et de nickel. Le chrome et le nickel sont, de façon intéressante, également ferromagnétiques, quoique bien moins que le fer. Toutefois, au sein d’un inox, le nickel en particulier pousse l’acier dans sa globalité à former une structure FCC, qui n’est pas ferromagnétique.

Le chrome quant à lui peut, dans certains cas, stabiliser la configuration austénitique de l’acier — qui est FCC — à température ambiante, le rendant non-ferromagnétique ; alors que normalement, l’acier austénitique chaud redevient férritique à température ambiante.

Dans l’ensemble, donc, grâce à la présence du nickel, et selon les traitements en présence du chrome, les alliages d’acier inoxydables peuvent ou non présenter un caractère ferromagnétique, et donc être attiré par un aimant.

Le choix d’un type d’alliage ou d’un traitement dépend des propriétés recherchées. Le magnétisme est alors un effet de bord, à moins que ce soit lui-même la propriété recherchée.

Note : l’acier peut se présenter également sous une autre forme courante appelée martensite : c’est ce que l’on obtient lors de la trempe de l’acier ou lors de certains traitements mécaniques (y compris à froid). Ici, le cristal BCC du fer est fortement perturbé par la présence d’atomes de carbone isolés par un refroidissement brusque, au point de se réorienter la structure cubique centrée en une structure tétraédrique centrée (BCT). C’est la conséquence d’un refroidissement brutal (la trempe), qui empêche la migration du carbone en « îlots ». Cette structure maintient les liaisons cristallines tendues, durcissant fortement le métal obtenu, mais la rendant également plus cassant. La martensite est généralement ferromagnétique aussi.

Conclusion

Si l’on entend parfois que l’inox n’est pas magnétique, ce n’est donc que partiellement vrai. Certains inox ne sont effectivement pas attirés par des aimants, mais d’autres le sont bel et bien. En cause la phase cristalline. Cette phase peut être déterminée par la composition, le traitement thermique ou mécanique subi (certaines étapes de mise en forme par forgeage modifient la structure cristalline).

Si je résume dans un tableau :

| Type d’acier | Phase | Composition | Structure | Aimantable | Exemples |

|---|---|---|---|---|---|

| Ferrite | Fer-α | Fe, ou Fe, C | BCC | Oui | Fer et acier² à température ambiante |

| Austénites (incl. inox) | Fer-γ | Fe, C, Cr, Ni, Mn… | FCC | Non | Acier² entre 910 °C et 1 394 °C ; Inox 304, 316… |

| Martensites | Fer-α | Fe, C, Cr… | BCT | Oui | Aciers² et Inox trempés 410, 420, 440… |

À titre d’expérience à faire chez vous, vous pouvez vous promener dans la maison avec un aimant et tester les différents éléments en acier ou en inox se trouvant chez vous. Attention à ne pas confondre avec de l’aluminium, du nickel, du laiton, ou d’autres métaux.

Parmi les pièces en aciers inox qui ne réagiront pas, j’ai trouvé notamment chez moi :

- certaines poignées de portes ou fenêtres ;

- les parois ou couvercles des casseroles en inox (mais pas le fond, qui contient de la fonte) ;

- la robinetterie en inox.

- …

Notes et références

- [1] : la structure du diamant n’est pas exactement cubique, mais dérive du cubique face centrée avec en plus un atome dans chacune des diagonales ; appelé, justement, structure « cubique diamant ».

- [2] : ici quand je parle d’acier, il s’agit d’aciers simples, alliages de fer et de carbone, sans autre additif comme dans l’inox.

Références :

- Tempering (metallurgy) — Wikipedia ;

- Autenite — Wikipedia ;

- ELI5: Why is some stainless steel magnetic and other stainless steel is not magnetic? : explainlikeimfive ;

- Is stainless steel magnetic? - thyssenkrupp Materials ;

- Easy Inox | Le magnétisme de l’inox : mythes, réalité et applications.

Image d’en-tête de Google AI / Gemini.

C’est quoi les verres auto nettoyants ?

Couleur science par Anonyme le 04/09/2025 à 04:52:00 - Favoriser (lu/non lu)

Le verre est un matériau très ancien, mais la technologie actuelle est capable de lui conférer des propriétés diverses et fascinantes. Il est transparent par nature, mais on peut :

- l’opacifier sur demande, grâce aux UV ou grâce à l’électricité

- le rendre polarisant ;

- le rendre transparent dans un seul sens ;

- le rendre résistant à la température ;

- ou encore hydrophobe.

- et en l’alliant avec du plomb, cela devient du cristal, aux propriétés optiques et acoustiques particulières.

Une des possibilités supplémentaire est de le rendre auto-nettoyant et auto-désinfectant.

Le côté nettoyant repose en réalité sur une action de l’eau. Cette action est altérée d’une façon avantageuse par le revêtement qu’on mettra dessus.

Ce revêtement peut être aussi bien hydrophobe que hydrophile.

Sur une vitre rendue hydrophobe, l’eau perle sans s’accrocher. La saleté accumulée (poussière, bactéries, fientes d’oiseaux…), est alors entrainée par l’eau et évacuée, rendant la vitre propre, alors qu’une vitre normale, bien plus hydrophile, aurait maintenu la goutte d’eau en place et son assèchement aurait fixé la saleté sur la vitre.

Inversement, sur une vitre dont le traitement est hydrophile, et donc où l’eau s’étend dans un fin film uniforme, la saleté est également étendue, mais le revêtement comprend alors des composés comme le dioxyde de titane, qui agit comme un catalyseur dans la décomposition des molécules organiques par les UV. Le côté hydrophile permet d’augmenter la surface de contact avec le verre et son revêtement.

Pour rappel, un catalyseur est un composé qui accélère une réaction chimique sans faire partie de cette réaction. Les UV décomposent naturellement les composés organiques avec le temps, mais c’est beaucoup plus rapide avec un traitement spécifique. Le dioxyde de titane ici n’est donc pas consommé et reste sur la vitre.

Les composés organiques dont il est question peuvent être de la saleté, mais aussi des bactéries. Une vitre qui débarrasse sa surface de ça est donc automatiquement désinfectante. Sur une vitre exposée à la pluie et à la lumière du Soleil, l’ensemble est passif.

En laboratoire, pour la stérilisation, on peut utilise un système à UV, qui est plus pratique qu’utiliser une brosse et divers produits (alcool, chlore, ozone…). Les traitements auto-nettoyants améliorent l’action des UV.

Ces verres spéciaux sont également utilisés sur certaines protections d’écrans de téléphones haut de gamme, mais il faut que l’ensemble laisse toujours fonctionner le côté tactile et reste entièrement transparente.

C’est quoi l’effet tunnel en physique quantique ?

Couleur science par Anonyme le 07/08/2025 à 18:32:00 - Favoriser (lu/non lu)

L’effet tunnel est un exemple d’effet étrange mentionné dès que l’on parle de physique quantique. À quoi correspond-il ? Comment l’expliquer ?

La définition de l’effet tunnel, si je prends Wikipédia, c’est ça :

L’effet tunnel désigne la propriété que possède un objet quantique de franchir une barrière de potentiel même si son énergie est inférieure à l’énergie minimale requise pour franchir cette barrière.

Ça semble très compliqué, et cet article va essayer de clarifier tout ça.

Dans cette définition, ce qu’ils appellent « un objet quantique » est typiquement une particule élémentaire, par exemple un électron. Dans la suite de l’article, l’on prendra effectivement un électron en exemple, mais le principe reste similaire pour toute autre particule.

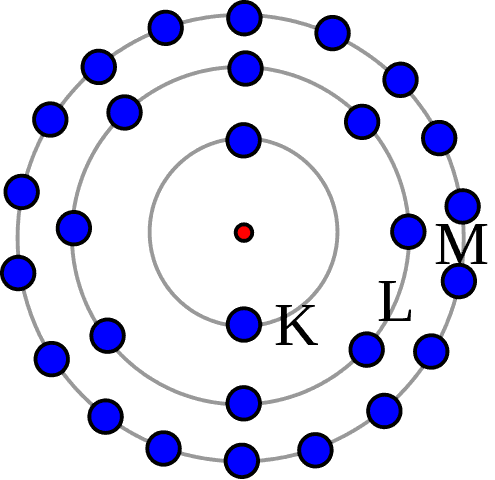

Modèle atomique

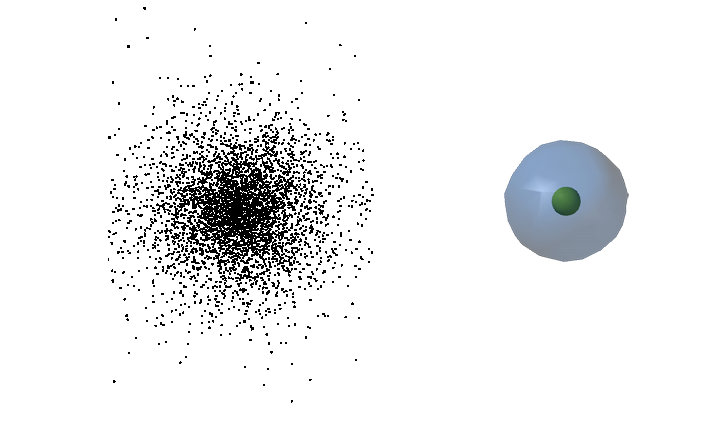

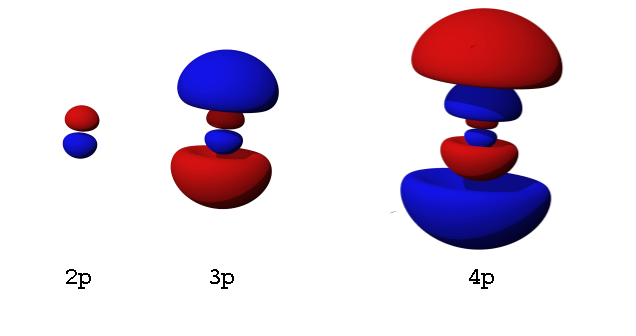

On dépeint classiquement un atome comme des électrons sur des orbites fixes autour d’un noyau central. Cette vision est populaire, mais loin de la description moderne de l’atome. Comme expliqué dans mon article sur le modèle atomique et les couches électroniques, on sait aujourd’hui que les orbites des électrons ne sont pas comme ça. En fait, même les électrons ne sont pas comme ça : on ne les voit plus comme des petites billes.

Dans la compréhension moderne du modèle atomique, les électrons sont représentés par une fonction d’onde ayant une composante probabiliste. Cela veut dire que l’électron correspond à tout le nuage à la fois. Le nuage contient l’électron et ce dernier ne prend une position fixe que lorsqu’on le mesure. Cette position enfin, est, elle, définie par des probabilités.

L’on connait très bien les probabilités, mais pas l’issue de ces probabilités. Voyez ça comme un jeté de dés : on sait que l’on a très exactement une chance sur six de faire un 6, mais on ne sait pas prévoir si le prochain lancé sera effectivement un 6.

Cette nuance est très importante et elle a deux conséquences :

- La première c’est que ce n’est pas parce que l’on a à faire à des probabilités que l’on nage dans le flou. On connait les probabilités.

- Inversement, la parfaite connaissance de règles de probabilité ne nous donne pas une vue sur l’avenir pour autant. Les probabilités sont connues, pas leur issue.

Poursuivons. Un nuage — météorologique je veux dire — n’est pas clairement délimité. De loin, on voit une zone aux allures finies, mais quand on s’en approche, on entre dedans de façon très progressive, comme dans un brouillard. Si l’on voulait délimiter ce nuage, il faudrait poser une règle arbitraire. Par exemple « le moment où l’air contient 25 gouttelettes par mètre cube, pas avant », ou encore « le moment où 5 % de la vision est obstruée par des gouttelettes ».

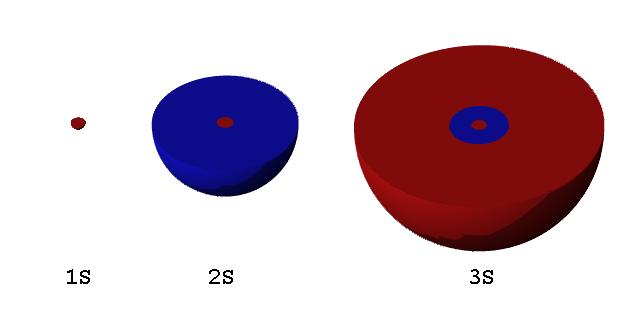

En physique quantique, c’est un peu pareil. Le nuage électronique autour d’un atome s’étend théoriquement jusqu’à l’infini, et englobe donc tout l’univers. Pour que l’on puisse avoir une représentation plus compréhensible, on va délimiter la zone qui a une probabilité de 90 % de trouver l’électron. Dans ce cas, l’électron a 90 % de chance de se trouver dans cette limite et seulement 10 % ailleurs ; où « ailleurs » est synonyme de « partout ailleurs dans l’univers » :

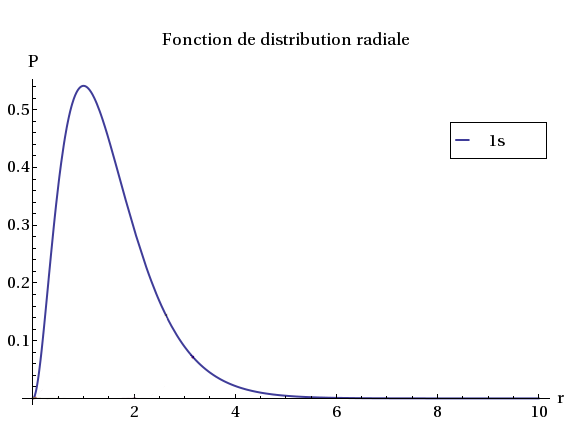

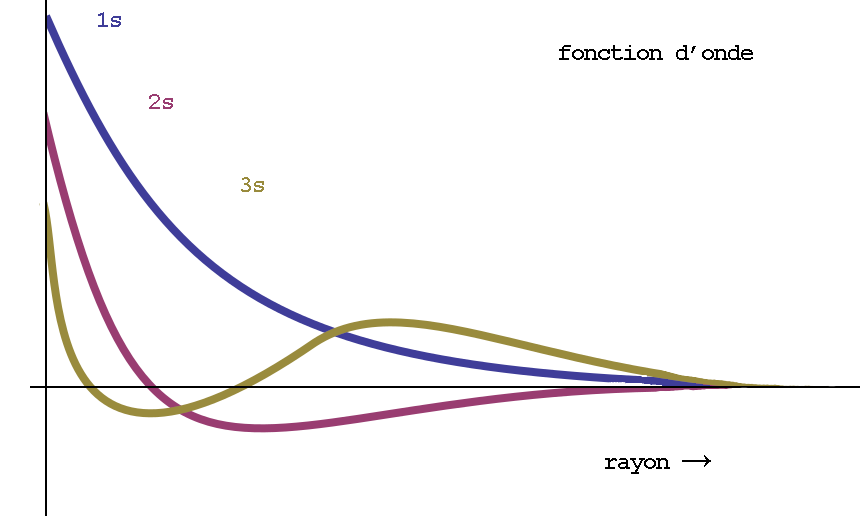

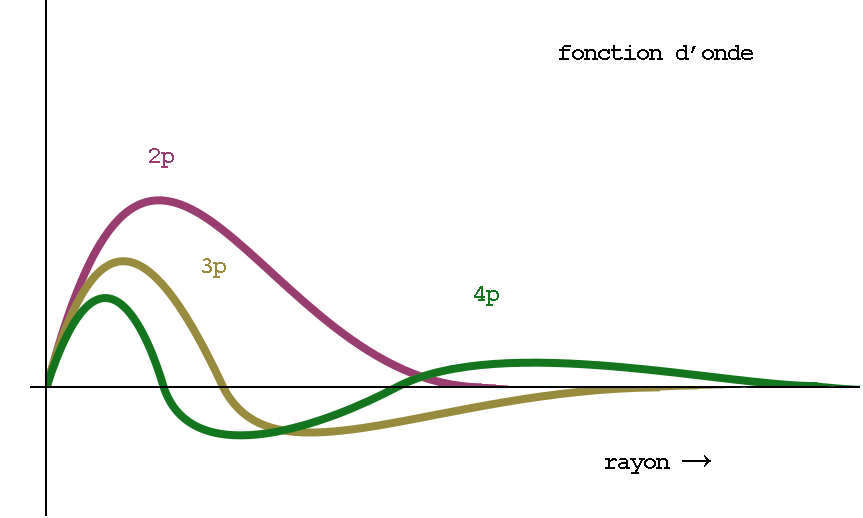

Cette probabilité peut être représentée par une fonction : la fonction de distribution de présence de l’électron. En particulier, la fonction de distribution radiale donne la probabilité de présence en fonction de la distance au noyau, le tout dans une direction donnée — les nuages électroniques n’étant pas forcément isotropes, on aura aussi une composante directionnelle, ou angulaire, autour du noyau, mais on va ignorer ça pour le moment (et de toute façon elles n’ont pas d’importance pour les électrons 1s ou 2s).

La représentation graphique en 2D de la fonction de distribution radiale donne une courbe, où l’origine représente le centre du noyau, x la distance à ce noyau et y la probabilité de trouver l’électron.

Pour l’orbitale 1s de l’hydrogène ci-dessus, il y a un seul lobe qui est une sphère centrée sur le noyau. La probabilité est nulle au niveau du centre du noyau lui-même, élevée au niveau du rayon atomique (r=1), mais décroît ensuite très vite vers zéro si l’on s’en éloigne.

La probabilité de trouver l’électron 1s loin du noyau est donc très faible. Faible, mais pas nulle.

Notion de barrière de potentiel

Une barrière de potentiel, classiquement, c’est une colline vers laquelle l’on fait rouler un ballon. Si le ballon ne va pas assez vite, alors elle ne franchira pas la colline. Le potentiel gravitationnel est trop élevé pour que le ballon, qui n’a pas suffisamment d’énergie, puisse le vaincre.

En soi, un potentiel peut être de n’importe quelle nature : potentiel électrique, chimique, magnétique, gravitationnel… Si l’on fait rouler un aimant vers un champ magnétique, il peut être repoussé également, faute de rouler assez vite.

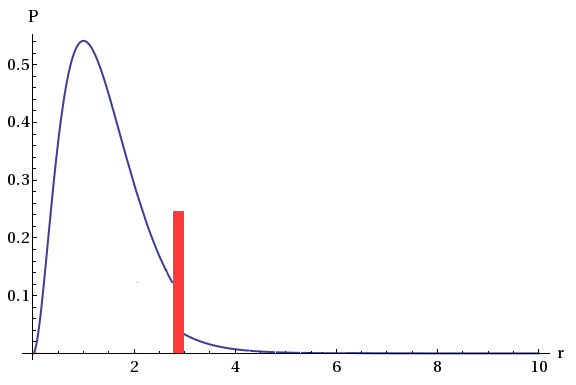

Pour l’électron d’un atome donné, la barrière de potentiel peut-être un champ électrique porté par un autre atome. Toutefois, contrairement au ballon qui est totalement stoppé par la colline et ne passera donc jamais la barrière s’il n’a pas assez de vitesse, l’électron n’est pas totalement stoppé lorsqu’il rencontre le second atome : sa probabilité de présence dans l’autre atome est simplement atténuée.

Ainsi, au lieu d’une fonction de distribution comme celle plus haut qui serait tronquée à cause de la barrière, on peut avoir une courbe où la barrière ne fait qu’atténuer la fonction, sans la bloquer complètement :

(cette représentation est faite habituellement avec la fonction d’onde directement, pas avec la fonction de distribution, mais les deux sont liées et cette représentation me semble plus simple à comprendre)

Ce qu’il faut voir ici, c’est que si l’on mesure la position de l’électron, alors elle sera de l’autre côté de la barrière seulement 1 % du temps, alors que sans la barrière on aurait pu avoir 10 %. La probabilité d’avoir l’électron de l’autre côté de la barrière est clairement diminuée, mais pas annulée, elle peut s’y trouver, quand bien même cette barrière était initialement trop élevée par rapport à l’énergie de l’électron.

Maintenant, l’on peut imaginer de l’autre côté un atome qui va « emprisonner » notre électron à l’instant même où il aura franchi la barrière. Il suffira donc juste que l’électron se présente de l’autre côté pour l’y piéger. Piéger l’électron revient à modifier sa probabilité de présence afin que désormais, elle soit 99 % à droite et seulement 1 % à gauche. En somme : on l’empêche de retourner d’où elle vient.

Ce piège peut être réalisé par la présence d’un autre atome en manque d’électron (un ion, un cation). D’un point de vue classique : l’électron est alors comme capté par ce cation après s’être échappé de son atome initial. Dans ce cas, on parle d’un puits de potentiel. Classiquement, c’est comme si le ballon tombait dans un trou et y restait.

Si l’on fait le bilan : on a donc un électron qui est passé de l’autre côté d’une barrière alors qu’il n’avait pas l’énergie pour ça initialement. Aucun effet classique ne peut l’expliquer : seule la physique quantique le peut. Cet effet est réel, et c’est cela que l’on appelle l’effet tunnel.

La dénomination provient du fait que si l’on appliquait ça à un ballon, le ballon devrait creuser un tunnel à travers la barrière, à défaut de passer par-dessus.

Comment c’est possible ?

Nous n’avons pas d’yeux suffisamment petits pour aller voir directement le mécanisme responsable de l’effet tunnel. Cela n’empêche pas de voir l’effet ou ses conséquences se produire.

La seule façon de se représenter ça, c’est mathématiquement, avec des équations. L’expérience est alors là pour comparer la réalité à nos prédictions mathématiques, et une concordance permet alors de dire si notre modèle théorique fonctionne ou non. Et la physique quantique, pour le moment, fonctionne incroyablement bien. Les sciences physiques c’est ça : retrouver par l’expérience, par des essais successifs, le modèle mathématique qui décrit le mieux un phénomène rencontré, puis de valider cette équation.

Une équation ne donne pas la raison de l’existence du phénomène, mais elle nous dit si le phénomène s’applique, et si oui, dans quelle mesure. La raison de son existence est une autre question à laquelle répondre est parfois plus délicate.

Pour dire pourquoi et comment ça marche, toutefois, il faut voir que l’électron, son paquet d’onde en fait — l’objet qui combine la particule et l’onde — va interagir avec la barrière de potentiel (ou l’objet qui lui donne source).

Cette interaction est telle que plus le paquet d’onde pénètre dans la barrière, plus elle est atténuée. Et plus il s’atténue, plus il sera enclin à plutôt rebondir contre la barrière :

Si la barrière de potentiel est fine, alors elle n’est pas totalement atténuée lorsqu’elle atteint l’autre côté de la barrière : elle peut donc en ressortir avec une probabilité décente et observable.

Dans la vie courante, on peut observer un phénomène analogue à une impulsion sonore. Quand un son rencontre un obstacle, il y a toujours une partie de l’onde qui est réfléchie, et une partie qui est transmise dans l’obstacle. Si l’obstacle est épais, l’onde transmise finira dissipée et ne sera pas audible de l’autre côté. Si l’obstacle est très fin, la partie transmise franchira l’obstacle en passant à travers.

Ainsi, si l’on est dans une cathédrale, les murs en pierre épais vont favoriser une réflexion des ondes sonores : c’est ce qui donne cet effet de résonance et d’écho. Si l’on recouvrait tous les murs de mousse isolante, l’écho disparaît : l’onde est absorbée et dissipée en chaleur, plutôt que réfléchi ou transmise. Et si l’on remplaçait les murs par des fines cloisons en papier, l’onde sonore va mettre en vibration le papier et quelqu’un de l’autre côté vous entendra facilement : l’onde est transmise sans être ni absorbée ni réfléchie.

Pour un paquet d’onde, on veut le voir de façon similaire : le paquet d’onde va en partie rebondir sur la barrière de potentiel, et en partie pénétrer à l’intérieur, voire, si la barrière est fine, passer à travers.

En n’oubliant pas — et c’est là où l’analogie avec l’onde sonore s’arrête — que le paquet d’onde ne passe pas partiellement à travers : elle n’est pas divisée en deux. C’est sa probabilité qui l’est. Mais l’électron lui-même n’est pas sécable et sa présence ne se mesure toujours qu’à un endroit : on pourra observer la particule aussi bien dans l’un que dans l’autre, par exemple en répétant l’expérience plusieurs fois de suite avec plusieurs électrons : une partie des électrons seront réfléchis par la barrière de potentiel, et une autre partie auront réussi à traverser la barrière de potentiel.

Où observer ce phénomène ?

On voit les conséquences de l’effet tunnel tous les jours et on sait même le mettre à profit.

Dans la nature, un exemple notoire est qu’il fait briller le Soleil. L’énergie nucléaire des étoiles provient de la fusion des protons. Les protons fusionnent quand leur énergie cinétique leur permet de dépasser leur répulsion électrique. Cette répulsion constitue une barrière, appelée barrière Coulombienne, et qui est un type de barrière de potentiel.

Au cœur du Soleil et de beaucoup d’étoiles, la température est trop faible pour que la seule énergie cinétique des protons permette aux particules de franchir la barrière coulombienne. Il faudrait en effet des températures de l’ordre de 100 millions de kelvins, mais le Soleil n’est toujours qu’à 15 millions de kelvins.

Pourtant, la fusion se produit bien. Une explication réside avec l’effet tunnel : on explique le franchissement de la barrière coulombienne par l’effet tunnel. Une fois de l’autre côté de la barrière, les deux protons sont maintenus ensemble par l’interaction forte, qui constitue un puits de potentiel. La température thermodynamique rapproche les protons, mais l’effet tunnel est nécessaire pour ce dernier coup de pouce permettant d’obtenir la fusion.

Quant à l’exploitation artificielle de l’effet tunnel dans notre technologie, on peut citer : la mémoire flash des clés USB, cartes SD, mémoires de téléphones, disques SSD. Ils fonctionnent en piégeant des électrons sur des conducteurs isolés électriquement (les grilles flottantes — ou floating gate). L’isolant est franchi par effet tunnel, et les charges électriques ainsi chargées ou déchargées sur des pastilles isolantes constituent alors les bits stockés dans la mémoire.

Une autre application bien connue est le microscope à effet tunnel : on mesure un courant d’électron plus ou moins fort (permettant de faire des pixels plus ou moins lumineux d’une image globale), et ces électrons passent de l’échantillon au détecteur par effet tunnel.

Ressources

Comment fonctionnent les recharges dessicants pour déshumidificateur ?

Couleur science par Anonyme le 03/07/2025 à 04:47:00 - Favoriser (lu/non lu)

Si les billes dessicants en silicates adsorbent l’humidité de l’air en piégeant les molécules d’eau sur sa surface, les sachets-recharges pour déshumidificateur absorbent l’humidité sur le plan chimique, donc avec un mécanisme différent.

Absorption ou adsorption ?

Pour les billes en silicates, je parle d’adsorption, avec un « d ». À l’inverse, pour les recharges en poudre, je parle d’absorption, avec un « b ».

La différence est fondamentale : l’adsorption concerne un phénomène de surface, alors que l’absorption est un phénomène volumique. Dans le cas des billes en gel de silicates, l’eau est piégée dans les pores nanoscopiques à la surface de la matière. L’efficacité réside dans sa très grande surface spécifique. L’eau ne réagit pas chimiquement avec les silicates, mais est juste coincée dans les pores.

Les dessicants en recharge fonctionnent par absorption. Ils contiennent une poudre blanche de chlorure de calcium anhydre CaCl2. L’humidité vient réagir avec la poudre dans tout le volume : les molécules d’eau se lient aux ions du solide ionique. Notez que ce mécanisme n’est qu’un exemple d’absorption : l’absorption désigne seulement un processus ayant lieu en volume plutôt qu’en surface, pas si ce phénomène est physique, chimique ou d’une autre nature.

Que le pouvoir dessiccateur d’un composé soit obtenu par absorption ou adsorption, dans les deux cas, on parle d’un composé hygroscopique, c’est-à-dire un composé qui a une forte affinité avec l’eau, jusqu’à la retirer de l’air ambiante.

Absorption pour le chlorure de calcium

Le chlorure de calcium, CaCl2, est un solide cristallin ionique : la molécule est polarisée, car les électrons du calcium sont délocalisés vers les atomes chlore.

En présence d’humidité, les molécules d’eau, également polarisées, vont venir se fixer autour des atomes de chlore et de calcium, et y rester. L’eau va présenter son côté positif aux atomes de chlore et son côté négatif aux atomes de calcium et rester ainsi en place par des liaisons ion-dipôles.

Dans cet état, le chlorure de calcium est dit « hydraté » et n’est plus totalement le même composé chimique non plus. Dans son état le plus hydraté, chaque molécule de chlorure de calcium CaCl2 peut retenir typiquement 2, 4 ou 6 molécules d’eau. Par exemple, pour une tétrahydration (donc 4 molécules d’eau), on note cela ainsi :

Dans les pochettes dessiccatrices, la poudre de chlorure de calcium anhydre se charge et se décharge en eau en fonction de l’humidité relative du milieu : le composé « travaille ». Les grains de la poudre se soudent aussi petit à petit entre eux, formant un agglomérat plus ou moins uniforme et solide avec le temps.

Quand le sachet est dur comme et forme un seul bloc ressemblant à du plâtre, on peut se dire que le sachet est à changer.

D’autres exemples de composés hygroscopiques

Outre le chlorure de calcium, la soude caustique (hydroxyde de sodium) ou le bicarbonate de soude (bicarbonate de sodium) sont également de bons absorbeurs d’humidité : laissés à l’air libre, l’eau peut même se liquéfier autour : le composé se dissout dans l’humidité qu’il absorbe !

Le chlorure de sodium, c’est-à-dire le sel de table, est également concerné. Du sel laissé à l’air libre peut devenir collante voire faire comme la soude caustique et se dissoudre dans l’eau qu’elle absorbe. Le sel pourra être placé au soleil ensuite pour le sécher.

Dans certains cas, le composé anhydre et le composé hydraté ont des propriétés physico-chimiques différentes. Ils peuvent par exemple changer de couleur. Un cas bien connu est le sulfate de cuivre : blanc, il prend une couleur bleue vive en présence d’eau ou d’humidité. Il s’agit de l’eau qui libère les ions de leur structure cristalline solide, et ce sont ces ions, libres, qui sont colorés.

De la même manière, l’hydratation du chlorure de cobalt le fait passer du bleu pâle au rouge vif.

Enfin, si un système pour déshumidifier l’air est parfois nécessaire, un système à base de recharges n’est pas forcément pratique. Les pochettes de chlorure de calcium sont plutôt réservées à des petits endroits confinés, avec un très faible renouvellement d’air. J’ai découvert ça dans les phares de voitures à LED : les phares LED ne chauffent pas et ne permettent pas de dégager l’humidité aussi bien que des phares classiques. Les phares modernes sont également hermétiques pour une question de sensibilité à l’eau et à la poussière. Cela nécessite en contrepartie la présence d’un dessicant, qu’il faut périodique remplacer.

Dans les autres cas, notamment pour déshumidifier une pièce de la maison, on préférera des méthodes par condensations : un climatiseur ou un module Peltier refroidit l’air, ce l’assèche par condensation de son eau, qui goute alors dans un réservoir. C’est le principe de fonctionnement de la plupart des déshumidificateurs électriques domestiques. Il n’y a pas besoin de recharges, juste de vider l’eau quand le récipient est plein.

Liens

Comment fonctionnent les thermomètres mini-maxi ?

Couleur science par Anonyme le 05/06/2025 à 04:06:00 - Favoriser (lu/non lu)

Dans un thermomètre de type thermomètre à mercure, on a un tube contenant du mercure, un métal liquide1. Lorsque la température s’élève, le mercure prend du volume et monte dans le tube. La hauteur du mercure est directement liée à la température et il suffit de graduer le tube pour lire la température.

Généralement, les tubes sont terminés en bas par une petite fiole contenant du mercure. Le volume total de mercure étant plus important avec la fiole, la quantité de mercure qui se dilate est plus importante et cela amplifie l’amplitude de la variation de la hauteur de la colonne dans le tube, rendant la lecture plus facile :

Parfois la fiole est masquée dans la coque, qui sert alors aussi de protection.

Dans les thermomètres mini-maxi, l’on se retrouve avec deux colonnes. L’une d’elles est dans le sens du thermomètre normal décrit ci-dessus, mais l’autre, celle du mini, est inversée : les températures froides sont en haut et chaudes sont en bas. Aussi, si la température refroidit, le mercure remonte dans le tube mini.

On a également dans chaque tube une petite pastille qui flotte (littéralement) sur le mercure : ce sont les index montrant les minis et les maxi atteints.

Lorsque le mercure monte ou descend, les index suivent le mouvement, à ceci près que les index ne peuvent toujours que remonter dans le tube, pas descendre. Dans le tube maxi, le haut signifie la température chaude, et dans le tube mini, le haut signifie la température froide. Les index « mémorisent » donc les extrema de température ; d’où le nom d’un thermomètre mini-maxi.

Enfin, le thermomètre dispose d’un bouton de remise à zéro : enfoncé, les deux index redescendent au contact du mercure, remettant à zéro les lectures mini et maxi.

L’ensemble fonctionne sans pile ni source d’énergie extérieure.

Plusieurs questions se posent :

- comment, dans le tube mini, le mercure peut-il remonter avec un refroidissement ? Il devrait remonter (se dilater) avec la chaleur, pas le froid !

- comment fonctionne le bouton de remise à zéro ?

Ce dispositif très commun contient un peu de science très simple, mais le système reste ingénieux.

Si vous avez lu mon article sur le thermomètre de Galilée, avec les capsules colorées, vous savez que ce n’est pas la densité des capsules qui varie, mais la densité du liquide partout autour qui change avec la température. La leçon à en tirer est que la science se cache dans la partie que l’on a tendance à ignorer : le liquide transparent.

Dans le thermomètre mini-maxi c’est pareil : l’on voit le mercure bouger, mais ce n’est pas sa dilatation qui en est la cause, ni celle qui est intéressante. Sa dilatation est imperceptible ici.

De plus, il n’y a pas deux colonnes comme on pourrait croire, mais une seule. Le bouton de remise à zéro cache aussi des choses !

Voyons tout ça.

Un tube de mercure en « U »

Une des astuces utilisées est la forme du tube du thermomètre : il n’y en a qu’un et en forme de « U ». Les tubes mini et maxi correspondent aux deux barres verticales du U.

Le mercure, lui, ne se trouve que dans le creux du U. Le reste est rempli d’alcool transparent et donc invisible.

Dans ce tube en U, la fiole se trouve non pas en bas, mais en haut de la barre du mini et est pleine d’alcool. Le liquide se dilatant n’est donc pas le mercure, mais l’alcool !

La fiole se trouvant en haut, lors de la dilatation2 l’alcool progresse vers le bas au lieu de monter comme dans un thermomètre classique. L’alcool pousse alors le mercure à se déplacer dans le creux du U, et du mini vers le maxi.

Lorsque la température augmente, le mercure descend le tube mini, poussé par l’alcool, et mécaniquement, il remonte du côté « maxi ».

Au final, donc, le mercure ne se dilate pas (ou trop peu), mais est simplement poussé par l’alcool, qui lui se dilate. Inversement, quand la température baisse, il remonte du côté mini et descend du côté maxi, aspiré par la contraction de l’alcool, et suivant donc bien les graduations inversées.

L’ensemble n’est donc qu’un seul et même thermomètre où seul l’alcool se dilate significativement et où le mercure ne constitue qu’une « bouée » qui suit les variations de volume de l’alcool. La forme en U permet de mettre en haut les deux extrémités du volume de mercure, et sur lesquelles l’on a posé les deux pastilles.

Notez que l’alcool est assez fluide pour passer autour des index, qui ne bougent que poussés par le mercure.

Le mercure a une tension de surface assez important pour ne pas mouiller l’index, mais le repousser. Capacité que n’a pas l’alcool.

Et le bouton de remise à zéro ?

Le mercure pousse les index lorsqu’il les atteint, mais les index ne redescendent pas lorsque le mercure se retire. Pour les faire redescendre, on appuie sur le bouton : là, et seulement là, les index redescendent.

Comment ça marche ?

Le bouton repose sur un cadre contenant deux bandes aimantées qui longent les deux tubes. Les index contiennent quant à eux du fer métallique.

Les bandes magnétiques attirent donc les index vers eux, et les plaque contre la paroi du tube.

Le mercure pousse tout juste assez fort pour vaincre le frottement de l’index contre le tube en verre et les faire remonter. Par contre, lorsque le mercure se retire, le poids de l’index lui-même n’est pas suffisant pour le faire redescendre par gravité, et il reste donc plaqué contre la paroi, là où le mercure l’a posé :

Lorsque l’on appuie sur le bouton de remise à zéro, l’on éloigne simplement les aimants des deux tubes. Les index ne sont plus plaqués contre leur tube, et redescendent par gravité… jusqu’à revenir au contact du mercure.

Simplissime, mais il fallait y penser !

Conclusions

À nouveau — et à nouveau pour un thermomètre — la science a lieu ailleurs que là où l’on l’aurait attendu, à savoir dans le liquide (que l’on ne voit pas) entourant le mercure, et non au niveau du mercure lui-même.

Aussi, le bouton de remise à zéro fonctionne, avec des aimants (quoi d’autre ?).

Il s’agit globalement d’une mécanique assez triviale, mais je suis demandé comment ça fonctionnait lorsque je me suis retrouvé avec un tel thermomètre dans les mains.

Maintenant trivial ne signifie pas qu’il n’y a pas de technique derrière : il faut tout de même jauger divers paramètres comme la force des aimants et la quantité de fer dans les index : en contact, l’aimant doit bloquer la descente de l’index sans toutefois bloquer la montée, et quand on appuie sur le bouton, l’aimant ne s’éloigne que de quelques millimètres des deux tubes, mais cela doit être suffisant pour en réduire l’attraction.

Un tel thermomètre peut-être trouvé dans n’importe quel magasin de bricolage pour une quinzaine d’euros. On les trouve naturellement aussi sur Amazon.

Notes

[1] Aujourd’hui, le mercure n’est plus employé en raison de sa toxicité élevée. On préfère utiliser un liquide de type alcool coloré (en bleu ou en rouge typiquement). Pour les thermomètres qui ne descendent pas plus bas que −19 °C (comme les thermomètres médicaux, qui vont généralement de +35 °C à +43 °C) on utilise aussi du galinstan, un alliage métallique liquide de gallium, d’indium et d’étain.

Pour les thermomètres mini-maxi, on a toujours besoin de deux liquides non-miscibles et de densité différentes.

[2] La fiole étant en haut, l’alcool se dilate vers le bas. Lorsque la température baisse, la contraction le fait remonter. Précisons qu’à ces échelles, les forces de cohésion liquide (tension de surface) et de capillarité l’emportent très sensiblement sur les forces de gravité : c’est pour cela que le liquide n’a aucun mal à remonter.

Image d’en-tête : travail personnel.

Comment fonctionnent les encres qui changent à couleur changeante des billets euro ?

Couleur science par Anonyme le 01/05/2025 à 07:26:00 - Favoriser (lu/non lu)

Une technique anti-contrefaçons utilisée notamment sur les billets de banque sont les encres à couleur changeante. On le voit sur les billets de 50 € ou plus, notamment.

Comment ça marche ? Comment une encre peut-être être de plusieurs couleurs ?

Une couleur, zéro pigments

Habituellement, les couleurs sont produites par des pigments. Un pigment est une molécule qui lorsqu’elle reçoit la lumière incidente, absorbe une partie du spectre reçu, et renvoie le reste. La couleur du pigment correspond alors à la partie de la lumière qui est renvoyée.

L’espèce chimique utilisée dans le pigment détermine sa couleur. Si l’espèce chimique (la molécule) ne change pas, alors cette couleur ne change pas

Dans certains cas, les couleurs peuvent être produites sans pigments. C’est le cas de couleurs dites structurelles, où c’est la structure de la matière, l’agencement des atomes au niveau microscopique ou macroscopique qui est responsable de la production des couleurs, principalement grâce à des phénomènes d’interférences ondulatoire de la lumière, mais aussi de phénomènes relativistes, pour la couleur de l’or ou du cuivre par exemple.

Les encres qui changent de couleurs, ou encres optiquement variables tombent dans la catégorie des matériaux qui produisent de la couleur structurelle par phénomène d’interférences. Elles rejoignent donc les bulles de savon, les plumes de paon, les cristaux des pierres d’humeur sur les bijoux, les couleurs sur une flaque d’eau contenant du gazole, les couleurs obtenues avec un CD que l’on éclaire… bref, on en voit partout bien qu’on ne se pose pas souvent la question.

Contrôler la structure permet de choisir la couleur finale que l’on verra, mais on pourra aussi obtenir un effet de changement de couleur en fonction de l’inclinaison de la surface. Dans le cas des billets de 50 € mentionné au début, la partie encrée varie du vert au violet.

Origine d’une couleur structurelle

La couleur structurelle découle généralement de phénomènes d’interférences. On les reconnaît à leur aspect métallique, ou irisés.

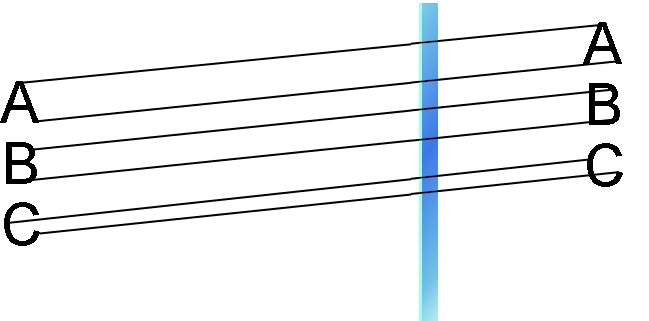

Au cours de ces phénomènes, un rayon de lumière incidente issu de la lumière ambiante se retrouve scindé en deux rayons identiques (même direction, même longueur d’onde) mais décalés, déphasés. Quand ces deux rayons se recombinent, ils agissent l’un sur l’autre : ils interfèrent. Leur amplitude peuvent alors s’additionner ou se soustraire en fonction du déphasage :

Si l’on a deux couleurs — deux longueurs d’ondes différentes — il est possible que l’une soit totalement annulée, et l’autre soit au contraire augmentée. Le déphasage est bien identique pour les deux longueurs d’onde, mais chaque longueur d’onde ne va pas réagir de la même façon.

C’est ce mécanisme qui permet de colorer des surfaces structurellement à partir d’une lumière blanche polychromatique.

Origine des interférences

Pour obtenir une couleur structurelle, il faut que les rayons incidents soient scindés. Les rayons ainsi obtenus vont interférer et produire la couleur par addition ou soustraction.

L’origine de la scission se produit typiquement avec des revêtements présentant une couche mince transparente, des petits orifices, ou rainures très fines.

Quelques exemples peuvent être :

- les sillons d’un CD-Rom (réseau de diffraction ; rainures)

- l’épaisseur d’eau d’une bulle de savon (couche mince)

- une couche d’huile ou de gazole sur une flaque d’eau (couche mince)

- les plumes de paon, de coq, de canard Col Vert, de pigeon (réseau de diffraction)

- les écailles de poisson, le dos de certains scarabées, les ailes de certains papillons (réseaux de diffraction + couche mince)

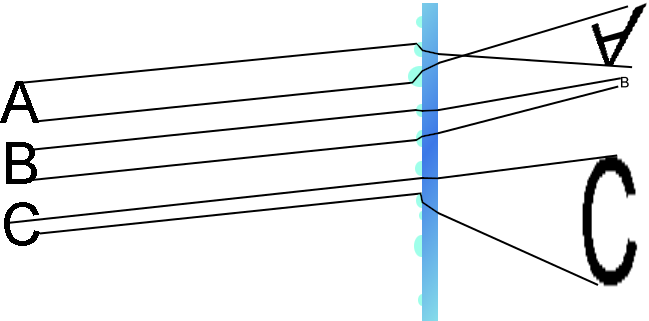

Dans ce cas des interférences par couche mince, une partie de la lumière est directement réfléchie sans entrer dans la couche transparente et l’autre passe dans la matière, se réfléchit à l’intérieur puis en ressort :

On peut remarquer que la partie transmise dans la couche mince du rayon va effectuer un trajet supplémentaire par rapport à la partie du rayon qui est réfléchi en surface. On parle d’une différence de marche dans le trajet optique.

C’est précisément la valeur de cette différence de marche qui va constituer le déphasage : les deux ondes initialement en phase au moment de se scinder en deux, vont être décalées au moment d’interférer.

Évidemment, le déphasage va dépendre de l’épaisseur de la couche mince, ainsi que de sa nature, mais ce n’est pas tout. L’inclinaison des rayons incidents va également être importante. En effet, plus le rayon est incliné, plus le trajet optique dans la couche mince va être importante, et cette augmentation fera varier le déphasage :

Sur la figure ci-dessus, on voit très bien que la différence de marche dépend de l’inclinaison. Il en résulte que selon l’inclinaison des rayons incidents, les couleurs issues des interférences vont également varier.

Cas des encres optiquement variables

L’effet où l’encre change de couleur en fonction de l’inclinaison vient de là : quand on incline le papier encré, on modifie en direct l’incidence et donc le déphasage, et par suite, la couleur résultante varie également.

Le déphasage est le même pour toutes les longueurs d’ondes, mais si l’on prend l’exemple d’un déphasage de 200 nm, celui-ci va totalement annuler les longueurs d’ondes de 400 nm (bleues), mais seulement partiellement les longueurs d’ondes de 500 nm (vert), 600 nm (jaune), ou rouges. Dans ces conditions, le bleu est annulé et retiré du spectre : la lumière blanche sans le bleu devient alors orange.

Si cette fois le déphasage est de 300 nm, les longueurs d’ondes de 400 nm (bleues) ne sont plus totalement annulées, mais le 600 nm (jaune), si. Le spectre blanc est donc dénué de jaune, et sera principalement rouge-bleu, donc violacé.

Selon l’angle, donc, les couleurs qui ressortent après interférences varient, et c’est ce qui provoque ces changements :

Conclusion